Découvrez l'IA : la technologie qui révolutionne notre quotidien

L'ère de l'intelligence artificielle a commencé

Aujourd'hui, l'intelligence artificielle (IA) est partout et change profondément nos vies.

Elle joue déjà un rôle prépondérant dans des domaines essentiels comme la médecine, en détectant rapidement des maladies graves à partir d'images médicales, parfois mieux qu'un expert. Elle aide aussi les scientifiques à piloter des robots sur Mars en prenant des décisions autonomes à des millions de kilomètres de distance.

L'intelligence artificielle est la capacité des machines à imiter des comportements humains comme apprendre, réfléchir ou prendre des décisions.

Comme toute grande avancée technologique, l'intelligence artificielle s'inscrit dans ce que l'économiste Joseph Schumpeter appelait la «destruction créatrice» : un processus où les anciennes méthodes sont remplacées par de nouvelles, plus efficaces. L'IA transforme déjà de nombreux métiers, automatise des tâches répétitives et ouvre de nouvelles perspectives dans la recherche, la production ou les services.

Les entreprises qui adoptent ces outils gagnent un avantage décisif en rapidité, en précision et en innovation, tandis que celles qui tardent à évoluer risquent de décrocher face à une concurrence de plus en plus agile.

Mais concrètement, comment ces algorithmes fonctionnent-ils et pourquoi sont-ils si puissants ?

Comment se les approprier pour croître, gagner en efficacité et en rapidité ?

Commençons d'abord par comprendre comment cette technologie fonctionne.

Les algorithmes : comment ça marche ?

Vous êtes-vous déjà demandé comment votre téléphone reconnaît votre visage ou comment votre application GPS trouve toujours le chemin le plus court ? Derrière ces prouesses technologiques se cachent des algorithmes. Un algorithme consiste en une série d'instructions précises, étape par étape, que la machine exécute pour réaliser une tâche ou résoudre un problème spécifique. Imaginez cela comme une recette de cuisine : chaque ingrédient et chaque étape compte pour arriver au résultat souhaité.

Un exemple simple : le perceptron

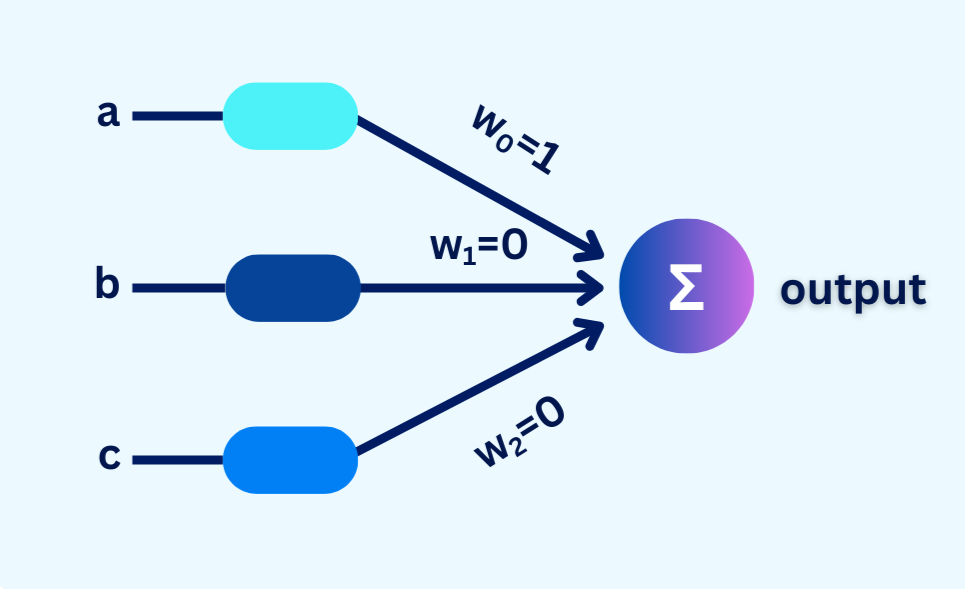

Voici un exemple très simple d'algorithme appelé le perceptron. Il s'inspire du fonctionnement des neurones dans le cerveau humain, interconnectés entre eux par des synapses. De manière similaire, un réseau de neurones artificiels est composé de "neurones" qui reçoivent des données en entrée et leur attribuent un poids.

Sur ce schéma, vous voyez trois entrées (inputs) : a, b et c. Chaque entrée est multipliée par un poids (w) qui indique son importance. Ensuite, il fait la somme des résultats. Si cette somme est positive ou dépasse un certain seuil, le neurone s'active et produit une sortie (output).

Par exemple, ici :

- Le poids w₀ est fixé à 1 : cela signifie que l'entrée "a" influence fortement le résultat.

- Les poids w₁ et w₂ sont à 0 : les entrées "b" et "c" n'ont actuellement aucune influence sur le résultat final.

Le résultat circule ensuite vers un autre neurone, et ainsi de suite, chaque neurone conservant un signal d'activation. Le perceptron effectue ainsi une classification binaire : il attribue une sortie de 0 ou 1 en fonction des données reçues.

Si le résultat ne correspond pas à ce qui était attendu, l'algorithme détecte l'erreur et la transmet en arrière pour ajuster les poids. Grâce à ce mécanisme, il est capable d'apprendre et de s'améliorer, jusqu'à produire des prédictions ou des décisions pertinentes.

Les algorithmes dans votre quotidien : l'exemple des CAPTCHA

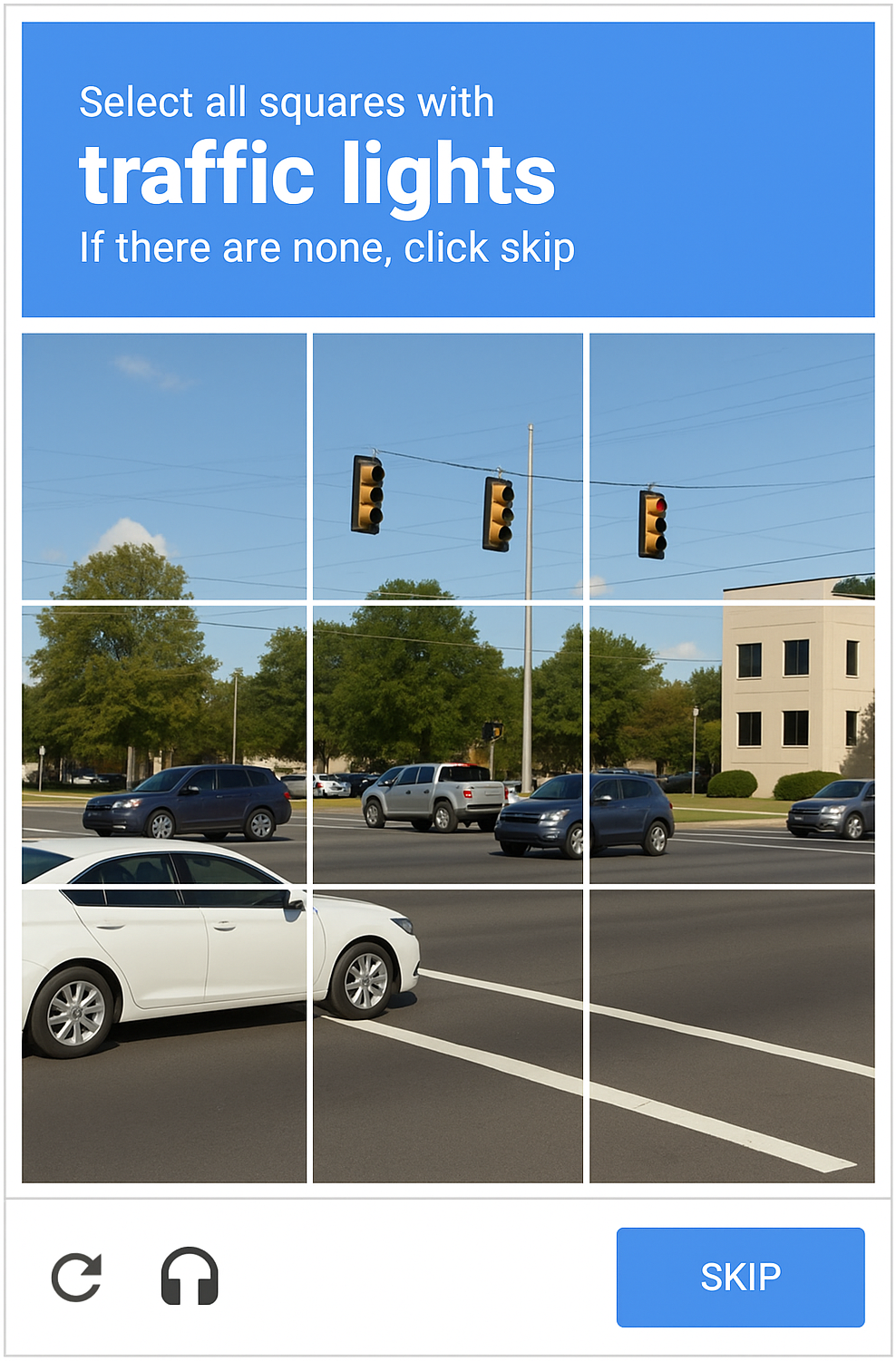

Sans le savoir, vous avez sûrement déjà aidé à entraîner des algorithmes avancés !

Lorsque vous cochez les images contenant un feu de circulation,

un vélo ou un piéton sur un CAPTCHA pour prouver que vous n'êtes pas un robot, vous contribuez en réalité à améliorer les performances des voitures autonomes.

Vos choix permettent aux algorithmes de ces véhicules intelligents de mieux identifier les éléments essentiels à la conduite, comme les piétons, les panneaux de signalisation ou les feux rouges. Ainsi, à travers un geste simple, vous participez indirectement à l'amélioration constante des technologies de demain comme la voiture autonome.

Langage de programmation

On confond souvent algorithme et programme, mais ce n'est pas la même chose. Un algorithme, c'est une méthode générale qui décrit les étapes pour résoudre un problème, sans dépendre d'un langage ou d'un outil particulier.

Un programme, quant à lui, est la réalisation de cet algorithme, écrit dans un langage informatique spécifique comme Python, Java ou C++, pour être compris par un ordinateur. Ainsi, un même algorithme peut donner naissance à plusieurs programmes différents selon les besoins ou les technologies utilisées.

Par exemple, créons un algorithme permettant de vérifier si un nombre est positif ou négatif. Nous choisissons d'écrire cet algorithme en utilisant trois langages de programmation différents. Nous aurons donc au final trois programmes distincts. Le premier est codé en Python, le second en Java, et le dernier en C++.

nombre = 10

if nombre > 0:

print("Le nombre est positif.")

else:

print("Le nombre est négatif ou nul.")public class Main {

public static void main(String[] args) {

int nombre = 10;

if (nombre > 0) {

System.out.println("Le nombre est positif.");

} else {

System.out.println("Le nombre est négatif ou nul.");

}

}

}#include <iostream>

using namespace std;

int main() {

int nombre = 10;

if (nombre > 0) {

cout << "Le nombre est positif." << endl;

} else {

cout << "Le nombre est négatif ou nul." << endl;

}

return 0;

}Python est devenu le langage de programmation par excellence, notamment dans les domaines de l'intelligence artificielle, de la science des données ou de l'automatisation. Contrairement à des langages plus anciens comme C++ ou Java, souvent plus lourds à écrire et à maintenir, Python se distingue par une syntaxe claire, intuitive, et proche du langage humain. Là où Java exige de nombreuses lignes pour réaliser une simple tâche, Python permet d'écrire du code concis et lisible, ce qui le rend particulièrement adapté aux débutants comme aux experts.

Par rapport à JavaScript, très prisé pour le développement web, Python se révèle plus polyvalent et bien mieux adapté aux domaines du traitement de données et de l'intelligence artificielle.

Face à R, un langage spécialisé en statistiques, Python se distingue par son approche plus généraliste, tout en disposant lui aussi de bibliothèques puissantes pour l'analyse de données (pandas, numpy) et l'apprentissage automatique (scikit-learn, TensorFlow).

Enfin, contrairement à MATLAB, largement utilisé dans les milieux scientifiques, Python a l'avantage d'être gratuit, open source, et tout aussi performant dans la majorité des cas d'usage.

Cette combinaison rare de simplicité, de puissance et de gratuité explique pourquoi Python est aujourd'hui le langage préféré dans les domaines les plus innovants.

Ce n'est d'ailleurs pas un hasard si Python est

enseigné par les plus grandes universités au monde, comme Harvard, dans leurs programmes consacrés à l'intelligence artificielle.

Bref historique &

sous-domaines de l'IA

L'histoire de l'intelligence artificielle commence bien avant nos smartphones et assistants vocaux. Dès les années 1950, Alan Turing pose les bases de la réflexion en imaginant une machine capable de penser, et propose son célèbre "test de Turing" pour évaluer l'intelligence d'une machine. Quelques décennies plus tard, en 1997, l'ordinateur Deep Blue développé par IBM marque les esprits en battant le champion du monde d'échecs Garry Kasparov, prouvant qu'une machine pouvait déjà surpasser l'homme dans certaines tâches complexes.

L'intelligence artificielle s'est développée au fil des décennies pour donner naissance à plusieurs sous-domaines complémentaires. On entend souvent parler de machine learning, de deep learning ou encore de réseaux de neurones. En réalité, ces concepts s'organisent comme des poupées russes : l'intelligence artificielle englobe le machine learning, qui inclut lui-même le deep learning. Ces sous-domaines se distinguent par leur niveau de complexité et les types de problèmes qu'ils peuvent résoudre.

-

L'« Intelligence Artificielle » est le domaine global qui regroupe toutes les techniques permettant à une machine d'imiter des comportements humains, comme comprendre, apprendre ou résoudre des problèmes.

Elle englobe le machine learning, le deep learning, et l'IA générative, qui en sont des branches spécialisées, chacune plus poussée et autonome que la précédente.

Exemple : lorsqu'un assistant vocal comme Siri comprend une question et y répond, plusieurs formes d'IA coopèrent : une partie reconnaît la voix (deep learning), une autre interprète le sens (machine learning), et parfois une IA générative formule une réponse naturelle. L'IA agit donc comme le chef d'orchestre qui coordonne les différentes capacités pour simuler une forme d'intelligence. -

Le « Machine Learning » est une méthode d'IA où la machine apprend à partir de données, au même titre que le deep learning ou l'IA générative.

Plus précisément, il s'agit d'un ensemble d'algorithmes qui permettent aux machines de repérer des motifs dans les données et d'en tirer parti pour accomplir une tâche,

sans avoir été explicitement programmées pour chaque étape.

Ce qui le distingue, c'est qu'il utilise des algorithmes plus simples qui nécessitent souvent une aide humaine pour choisir les bonnes caractéristiques à analyser.

Exemple : un programme de machine learning peut apprendre à détecter des emails indésirables (spam) en analysant des milliers de messages marqués comme spam ou non. Il ne "comprend" pas vraiment le contenu, mais identifie des motifs statistiques récurrents comme la fréquence de certains mots. -

Le « Deep Learning » fonctionne comme le machine learning, mais il utilise des réseaux de neurones complexes capables d'apprendre directement à partir des données brutes, sans intervention humaine.

Ce qui le rend unique, c'est sa capacité à gérer des données non structurées (images, sons, vidéos) et à extraire automatiquement les éléments pertinents.

Exemple : une voiture autonome utilise le deep learning pour analyser en temps réel les images de la route, détecter les piétons, les feux et les panneaux, sans qu'un humain ait programmé précisément ce qu'est un piéton ou un feu rouge. -

L'« IA Générative » repose aussi sur le deep learning, mais elle ne se contente pas de reconnaître ou de classer : elle crée de nouveaux contenus à partir de ce qu'elle a appris.

Ce qui la différencie, c'est son rôle créatif : l'algorithme ne répond pas juste à une question, il propose une solution ou une idée nouvelle.

Exemple : une IA générative peut produire une image réaliste d'un chat qui n'existe pas, ou rédiger un paragraphe de texte à partir de quelques mots-clés. Là où les autres sous-domaines analysent, elle invente.

Python : le langage qui parle à tout le monde

Créé au début des années 1990 par Guido van Rossum, Python avait pour ambition de rendre la programmation plus simple et plus lisible. Trois décennies plus tard, il est devenu l'un des langages les plus populaires au monde, utilisé aussi bien dans la recherche scientifique que dans les entreprises technologiques. Il est présent chez Google pour gérer ses systèmes internes, chez Netflix pour optimiser les recommandations de films, ou encore à la NASA pour le traitement des données spatiales.

Ce qui distingue Python des autres langages, c'est sa simplicité de syntaxe, proche du langage naturel, combinée à une grande polyvalence. Il peut servir à concevoir un site web, automatiser une tâche répétitive, piloter un robot, ou encore analyser de gros volumes de données. Un étudiant peut s'en servir pour créer un jeu en quelques lignes, un enseignant pour corriger automatiquement ses copies, et un analyste pour visualiser en un clic les ventes annuelles d'une entreprise.

L'une des grandes forces de Python repose sur ses librairies (ou bibliothèques). Ce sont des ensembles de fonctionnalités prêtes à l'emploi qui permettent de gagner un temps précieux.

Ces librairies, développées par une large communauté, sont comme des modules spécialisés : par exemple, matplotlib permet de tracer des graphiques, pandas facilite la manipulation

de tableaux de données comme dans Excel, et scikit-learn propose des outils pour construire des modèles de machine learning.

Grâce à elles, même les projets complexes deviennent accessibles avec peu de lignes de code.

Python est aujourd'hui incontournable en finance, car il permet de traiter rapidement de grandes quantités de données, d'automatiser des analyses, et de modéliser des prévisions complexes. Son code clair le rend accessible même aux profils non techniques, tout en offrant une puissance équivalente à celle d'outils professionnels. Un contrôleur de gestion peut l'utiliser pour suivre l'évolution du chiffre d'affaires, anticiper la rentabilité d'un investissement ou repérer des incohérences dans la comptabilité, le tout sans dépendre de solutions propriétaires fermées comme SAP, Oracle Hyperion ou certains modules avancés d'Excel intégrés à Microsoft 365.